声明:本文来自于微信公众号 头号AI玩家(ID:AIGCplayer),作者:月山橘,授权站长之家转载发布。

AI视频生成工具卷起来了!

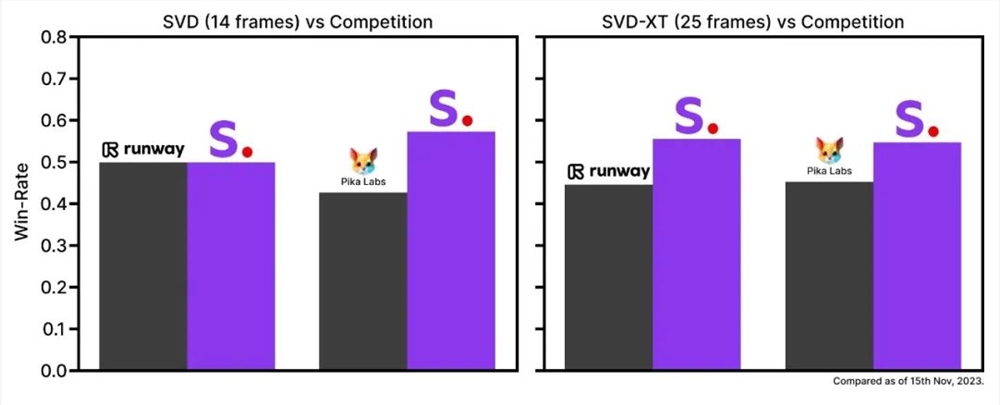

本周二,Stability AI低调发布了首个开源AI视频模型Stable Video Diffusion(以下简称SVD),同时还晒出测试数据称,SVD的模型性能碾压RunwayML、Pika Labs等领先的闭源商业模型。

大家可能不认识Stability AI,但一定听过它开发的、同样是开源的热门文生图模型Stable Diffusion(以下简称SD),不少人首次接触AI绘画,甚至AIGC领域,都是从SD开始的。

这次Stability AI下场,一个不小心又开源了AI视频模型,如今已集齐图像、语言、音频等多领域开源大模型,引得一众网友纷纷表示“终于等到你”,SVD上线消息不到48小时,X浏览量就破了80万。

热度拉满,SVD表现如何?

与市面上主流的AI视频生成模型功能类似,SVD支持用户输入文本或是图片来生成视频。

具体效果如何?先感受一波官方放出的亿点点震撼。

文生视频:

图生视频:

针对“图生视频”功能,Stable Video Diffusion提供两种版本模型,用户可以以每秒3~30帧之间的自定义帧速率生成SVD(14帧)和SVD-XT(25帧)的视频。

简单理解,帧率越高,视频画面越流畅。

值得一提是,Stable Video Diffusion还可以根据单个输入图像生成多个视角的视频内容。对创意视频工作者来说,这个功能非常炸裂。

例如,以往需要大费周章实拍的镜头,现在AI用一张图片就能生成多角度的视频素材,极大地节省拍摄人力和时间。

随着Stability AI加入视频生成模型混战,有网友不禁感叹:“先RunwayML,后meta,现在再来一个Stable Diffusion,恐怕不久,用AI就能搞定一整部电影了。”

这不,说来就来,网友们的“大片”已经刷屏X(推特)。

“燃烧的树”:

“会动的梵高星空”

“AI想象的未来世界”:

“3D太阳花”

其中在X上被疯转的一支视频,因为太过丝滑和流畅,真实到让人迷惑是不是信息流里混进了游戏录屏。

该视频出自X博主“fofr”,据他介绍,喂给SVD的参考图是Midjourney生成的,最终生成出来的效果连他自己都大受震撼:“就像真实的游戏镜头。”

拿原始参考图对比视频,不能说很像,只能说一模一样。

头一波尝鲜的X博主“歸藏”用SVD生成了一组包括人像、花卉、自然风景的视频,既有超现实的海上风景,也有像是电影实拍的人物肖像和自然花卉。

一番测试下来,“歸藏”认为SVD可以自动判断哪些地方该动以及应该怎样动,在复杂内容(如人脸)生成上不会出现像Runway一样画面崩坏的问题。

看到这里,“头号AI玩家”也忍不住去HuggingFace浅试了一波。

注意!这不是《塞尔达》游戏录屏,而是SVD根据游戏截图生成的AI视频

相关文章

相关文章

头条焦点

头条焦点

精彩导读

精彩导读 关注我们

关注我们

【查看完整讨论话题】 | 【用户登录】 | 【用户注册】