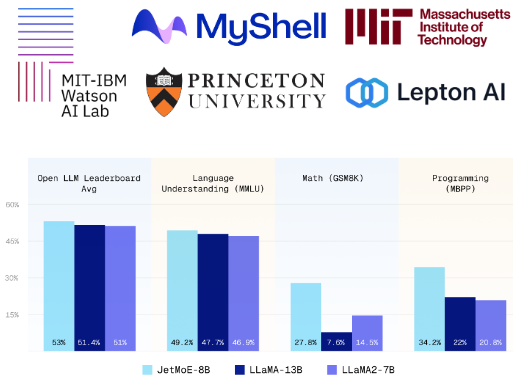

站长之家(ChinaZ.com)4月17日 消息:JetMoE-8B是一款采用稀疏激活架构的人工智能模型,其性能卓越且训练成本不到10万美元,令人惊讶的是,它的表现甚至超越了LLaMA2-7B、LLaMA-13B和DeepseekMoE-16B。

JetMoE-8B由24个块组成,每个块包含两个MoE层:注意力头混合(MoA)和MLP专家混合(MoE)。每个MoA和MoE层有8个专家,并且每个输入令牌激活2个专家。这种独特的设计使得在不牺牲性能的情况下显著降低了计算成本。

值得一提的是,尽管JetMoE-8B的总参数量达到80亿,但由于其特殊的架构设计,每个输入令牌仅激活约22亿参数,从而大大减少了总体的计算需求。

此外,JetMoE-8B的训练完全依赖于公开数据,并且整个训练过程,包括代码,都是完全开源的,这无疑为AI领域的研究和应用提供了极大的便利。

在与Open LLM排行榜相同的评估方法下,JetMoE-8B的性能表现优于LLaMA2-7B、LLaMA-13B和DeepseekMoE-16B,这一结果无疑是对其高效性能的最好证明。

与此同时,与具有类似训练和推理计算的模型(如Gemma-2B)相比,JetMoE-8B展示了更优异的表现。这不仅证明了其在性能上的优势,也展示了其在成本效益上的显著优势。

模型地址:https://huggingface.co/jetmoe/jetmoe-8b

相关文章

相关文章

头条焦点

头条焦点

精彩导读

精彩导读 关注我们

关注我们

【查看完整讨论话题】 | 【用户登录】 | 【用户注册】