声明:本文来自于微信公众号 新智元(ID:AI_era),作者:新智元,授权站长之家转载发布。

英伟达官方盘点2023年10大研究,从CV到AI,从智能体到生成式AI。英伟达不但现实世界中用GPU收割全世界,也在虚拟世界中用一项项匪夷所思的技术展开了一场革命。

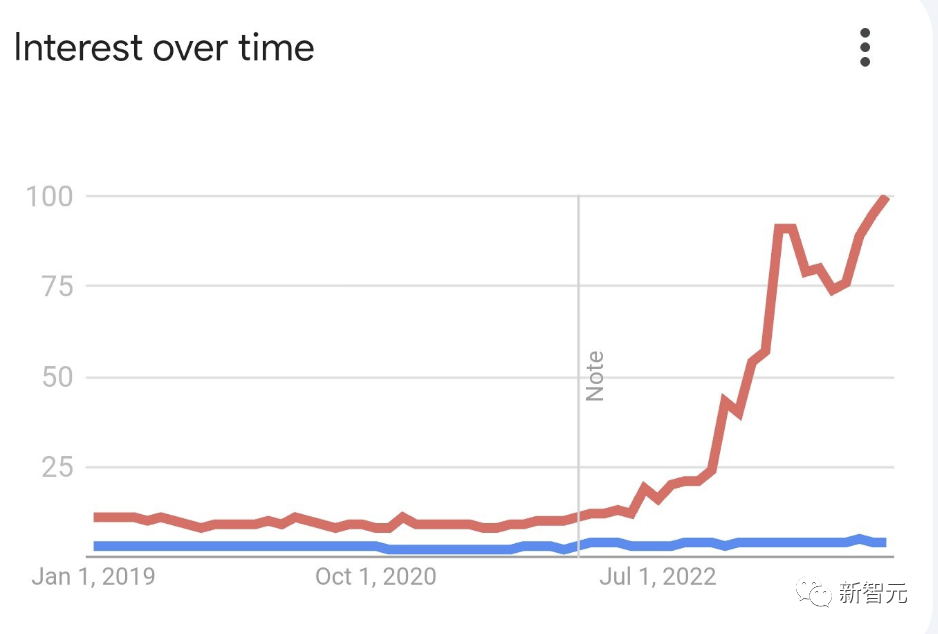

2023年,是人工智能爆炸式增长的一年。

红色代表人工智能,蓝色代表机器学习

微软、谷歌、Meta等科技巨头纷纷回顾了这一年研究成果。英伟达虽以卖算力成为全球GPU霸主,但在AI研究方面也毫不逊色。

对此,Jim Fan本人总结了,英伟达2023年研究的十大看点。

主题的主要分布:3个有关具身AI(机器人,虚拟角色);2个有关3D生成模型;2个图形处理;2个图像生成;1个视频生成的研究。

TOP1:「神经朗琪罗」让16世纪的大卫复活

来自英伟达和约翰霍普金斯大学的研究人员提出的新型AI模型,利用神经网络重建3D物体。最新研究还被CVPR2023录用。

论文地址:https://research.nvidia.com/labs/dir/neuralangelo/paper.pdf

特别是,Neuralangelo可以从手机视频,无人机拍摄的视频重建「高保真的大规模场景」。

Neuralangelo这项研究曾被TIME杂志评为「2023年200个最佳发明」之一。

以前的AI模型在重建3D场景时,往往难以准确捕捉到重复的纹理模式、均匀的颜色以及强烈的色彩变化。

为此,团队提出了一个将多分辨率3D哈希网格的表征能力和神经表面渲染相结合的全新方法——Neuralangelo。

去年,英伟达研究人员曾创造了一种新工具3D MoMa,将照片变成3D物体易如反掌。

NeuralAngelo建立在这一概念的基础上,允许导入更大、更详细的空间和对象。而它特别之处在于,可以准确捕捉重复的纹理模式、同质的颜色和强烈的颜色变化。

通过采用「即时神经图形基元」,也就是NVIDIA Instant NeRF技术的核心,Neuralangelo由此可以捕捉更细微的细节。

团队的方法依赖于2个关键要素:

(1)用于计算高阶导数作为平滑操作的数值梯度;

(2)在控制不同细节级别的哈希网格上进行由粗到细的优化。

即使没有辅助深度,Neuralangelo也能有效地从多视图图像中恢复密集3D表面结构,其保真度显著超过了以往的方法,使得能够从RGB视频捕捉中重建详细的大规模场景。

比如,Neuralangelo「复刻」出3D版的著名雕像大卫,大理石的细节、纹理栩栩如生。

要知道,收藏在佛罗伦萨美术学院的大卫雕像,仅身高3.96米,加上基座都有5.5米。

它甚至可以重建一栋建筑物的内外部结构,屋顶瓦片、玻璃窗格、还有各种细节都一一再现。

' fill='%23FFFFFF'%3E%3Crect x='249' y='126' width='1' height='1'%3E%3C/rect%3E%3C/g%3E%3C/g%3E%3C/svg%3E)

TOP2:对标DreamFusion,英伟达3D生成模型速度更快

Magic3D是一个可以从文字描述中生成3D模型的AI模型。

论文地址:https://arxiv.org/pdf/2211.10440.pdf

在输入诸如「一只坐在睡莲上的蓝色毒镖蛙」这样的提示后,Magic3D在大约40分钟内生成了一个3D网格模型,并配有彩色纹理。

Magic3D还可以对3D网格进行基于提示的实时编辑。想改变生成模型,只要改改文字提示,就能立即生成新的模型。

与谷歌DreamFusion方式类似,Magic3D同样是将低分辨率生成的粗略模型优化为高分辨率的精细模型,由此产生的Magic3D方法,可以比DreamFusion更快地生成3D目标。

从上面Magic3D的架构示意图可以看出,Magic3D以「由粗到细」的方式从输入的文本提示中生成高分辨率的三维内容。

整个生成过程分为两个阶段。

第一阶段,研究团队使用eDiff-I作为低分辨率文本-图像扩散先验。通过优化Instant NGP获得初始3D表示。

之后通过反复抽样和渲染低分辨率图像,不断计算Score Distillation Sampling的损失来训练Instant NGP。

优化后使用DMTet,从Instant NGP中提取一个粗略模型,并使用哈希网格和稀疏加速结构对其进行加速。

该扩散先验用于计算场景的梯度,根据64×64的低分辨率图像在渲染图像上定义的损失进行建模。

第二阶段,研究团队使用高分辨率潜在扩散模型(LDM),不断抽样和渲染第一阶段的粗略模型。

通过交互渲染器进行优化,反向生成512×512的高分辨率渲染图像。

TOP3:高逼真头发模拟

尽管当前取得了巨大的技术进步,头发和毛发模拟对动画工作室来说仍然是一个挑战。考虑重力、风、相互作用是一项计算密集型任务,无法实时准确完成。

英伟达研究人员实现了在GPU上计算头发模拟的新方法——ADMM,论文已被SIGGRAPH2023上展示。

论文地址:https://research.nvidia.com/publication/2023-08_interactive-hair-simulation-gpu-using-admm

总的来说,这项研究实现了使用AI来预测头发在现实世界中的行为方式。

比起先前的方法,它的性能更加强大,甚至,可以根据头发的复杂程度以交互帧率计算模拟,如下图所示,

论文研究者Gilles Daviet解释道,通过在各种场景中的测试,头发模拟每帧耗时在0.18-8秒之间。

简而言之,平均计算时间将根据各种因素而增加,比如头发数量和长度,或者如何精确处理碰撞。

至于内存,根据场景的不同,模拟所需的内存从1GB到2×9.5GB不等(在双GPU设置下)。

这种更快的头发模拟技术,可用于多种用途。

基于物理的编辑工具可用于调整现有的发型,同时保持弹性和自碰撞约束。

他创建的演示工具可以「统一缩放头发的长度和/或弧度;沿切割平面修剪发棒;以及通过类似弹簧的力在选择半径内直接操作发丝」。

TOP4:GPT-4加持,AI智能体完成复杂任务

英伟达、宾大、加州理工、德州奥斯汀等机构的专家提出一个开放式Agent——Eureka,它是一个开放式智能体,为超人类水平的机器人灵巧性设计了奖励功能。

论文链接:https://arxiv.org/pdf/2310.12931.pdf

英伟达等机构的研究人员开发出的Eureka系统,可以让GPT-4直接教机器人完成基本的动作。

比如,花样转笔。

具体来说,它是一个GPT-4加持的奖励设计算法,充分利用了GPT-4优秀的零样本生成、代码生成和上下文学习的能力,产生的奖励可以用于通过强化学习来让机器人获得复杂的具体技能。

在没有任何特定于任务的提示或预定义的奖励模板的情况下,Eureka生成的奖励函数的质量,已经能够超过人类专家设计的奖励!

具体来说,Eureka通过在上下文中发展奖励功能,实现了人类水平的奖励设计,包含了3个关键组成部分。

- 模拟器环境代码作为上下文,快速启动初始「种子」奖励函数。

- GPU上的大规模并行RL,可以快速评估大量候选奖励。

- 奖励反射可在上下文中产生有针对性的奖励突变。

TOP5:用LDM实现高分辨率视频生成

这篇论文介绍了Latent Diffusion Models(LDM)在高分辨率视频生成任务中的应用。

通过在低维潜空间中训练扩散模型,LDM实现了高质量图像合成,并避免了过多的计算需求。

论文地址:https://arxiv.org/pdf/2304.08818.pdf

研究人员将LDM应用于视频生成,并进行了微调,实现了对512x1024分辨率驾驶视频的优秀表现。

此外,研究人员还将现有的文本到图像LDM模型转换为高效、精确的文本到视频模型,并展示了个性化文本到视频生成的结果。

具体来说,这个模型生成的整体流程如下,先生成关键帧,然后也使用扩散模型进行插帧,将相邻帧的latent作为插帧片段的两端进行保留,中间待插入的帧latent用噪声初始化。

然后经过解码器,生成视频,再用超分模块。

在生成长视频和插帧时,使用mask-condition的方法,就是用一个二值的mask,通过给定一定的context帧的latent,来预测被mask的帧latent,可以通过迭代的方法生成长视频。

生成的视频效果如下,分辨率为有1280x2048像素,由113帧组成,以24fps的速度渲染,产生4.7秒的长剪辑。

这项用于文本到视频生成的视频LDM基于稳定扩散,总共有4.1B个参数,包括除剪辑文本编码器之外的所有组件。

在这些参数中,只有27亿是通过视频进行训练的。

具体用例中,比如可以进行多模态驾驶情景预测。

作为另一个可能相关的应用程序,研究人员可以采用相同的起始帧并生成多个看似合理的推出。在下面的两组视频中,合成从相同的初始帧开始。

TOP6:文本提示生成材质,并且将材质并无缝复制在任何表面上

项目介绍:https://blogs.nvidia.com/blog/siggraph-research-generative-ai-materials-3d-scenes/

英伟达研究人员凭借可帮助艺术家快速迭代3D场景的生成式AI模型演示,赢得了SIGGRAPH现场活动的最佳展示奖。

在演示中,英伟达研究人员在客厅场景下进行了展示。

研究人员使用OpenUSD来添加砖纹理墙,创建和修改沙发和抱枕的面料选择,以及将抽象的动物设计融入了墙壁的特定区域。

在包括建筑、游戏开发和室内设计在内的创意产业中,这些功能可以帮助艺术家快速探索想法并尝试不同的美学风格,以创建场景的多个版本。

而这个完全基于物理的材质生成功能将通过英伟达Picasso基础模型平台提供服务。

通过英伟达Picasso基础模型平台,企业开发人员、软件创建者和服务提供商可以选择训练、微调、优化和推断图像、视频、3D 和360HDRi 的基础模型,以满足他们的视觉设计需求。

TOP7:CALM——训练可操纵虚拟角色在物理模拟中执行动作的方法

项目地址:https://research.nvidia.com/labs/par/calm/

CALM是一种为用户控制的交互式虚拟角色生成多样化且可定向行为的方法。

通过模仿学习,CALM 可以学习运动的表示形式,捕捉人体运动的复杂性和多样性,并能够直接控制角色运动。

该方法联合学习控制策略和运动编码器,该编码器可以重建给定运动的关键特征,而不仅仅是复制它。

结果表明,CALM 学习语义运动表示,从而能够控制生成的运动和风格调节,以进行更高级别的任务训练。

CALM由3个部分组成:

在低级训练期间,CALM学习编码器和解码器。编码器从运动参考数据集中获取运动、关节位置的时间序列,并将其映射到低维潜在表示。

此外,CALM 还联合学习解码器。解码器是一个低级策略,它与模拟器交互并生成与参考数据集类似的运动。

第二个阶段:方向性控制

为了控制运动方向,研究人员训练高级任务驱动策略来选择潜在变量。

这些潜在变量被提供给生成所请求的动作的低级策略。

在这里,学习到的运动表示可以实现某种形式的风格调节。为了实现这一点,运动编码器用于获取所请求运动的潜在表示。

然后,向高级策略提供与所选潜在变量和代表所请求风格的潜在变量之间的余弦距离成比例的额外奖励,从而指导高级策略采用所需的行为风格。

第三阶段:推理

最后,将先前训练的模型(低级策略和方向控制器)组合起来组成复杂的动作,而无需额外的训练。

为此,用户生成一个包含标准规则和命令的有限状态机 (FSM)。它决定了执行哪个动作,类似于用户如何控制视频游戏角色。

比如,开发人员可以构建一个 FSM,如 (a)「蹲下走向目标,直到距离 <1m」,然后 (b)「踢」,最后 (c)「庆祝」。

TOP8:通过比赛视频让虚拟角色学习网球技能

项目地址:https://research.nvidia.com/labs/toronto-ai/vid2player3d/

英伟达研究人员提出了一个系统,它可以从广播视频中收集的大规模网球比赛演示中学习各种物理模拟的网球技能。

他们的方法建立在分层模型的基础上,结合了低级模仿策略和高级运动规划策略,以在从广播视频中学习的运动嵌入中引导角色。

当大规模部署在包含大量现实世界网球比赛示例的大型视频集上时,研究人员的方法可以学习复杂的网球击球技巧,并将多个镜头真实地链接在一起形成扩展的比赛,仅使用简单的奖励,并且无需明确的击球注释类型。

为了解决从广播视频中提取的低质量运动,研究人员通过基于物理的模仿来校正估计的运动,并使用混合控制策略,通过高级策略预测的校正来覆盖学习运动嵌入的错误方面。

系统可以合成两个物理模拟角色,通过模拟球拍和球的动力学进行长时间的网球比赛。

系统包括四个阶段。首先,研究人员估算2D和3D球员姿势以及全局根部轨迹,以此创建运动数据集。

其次,训练一个低层次的模仿策略,用于模仿运动数据,控制模拟角色的低层次行为,并生成一个物理修正的运动数据集。

接下来,研究人员对修正后的运动数据集进行条件变分自编码器(VAE)的拟合,以学习一个低维的运动嵌入,从而产生类人的网球动作。

最后,训练一个高层次的运动规划策略,通过结合运动嵌入输出的身体动作和对角色腕部运动的预测修正,生成目标运动姿态。

然后,通过低层次策略模仿这一目标动作,以控制物理模拟的角色执行所需任务。

TOP9:高效、高质量的网格优化方法——FlexiCubes

项目地址:https://research.nvidia.com/labs/toronto-ai/flexicubes/

这项研究是基于梯度的网格优化。研究人员通过将3D 表面网格表示为标量场的等值面来迭代优化3D 表面网格,这是摄影测量、生成建模和逆向物理等应用中越来越常见的范例。

现有的实现采用经典的等值面提取算法。这些技术旨在从固定的已知字段中提取网格,并且在优化设置中,它们缺乏表示高质量特征保留网格的自由度,或者遭受数值不稳定的影响。

研究人员提出了FlexiCubes,这是一种等值面表征,专门用于优化几何、视觉甚至物理目标方面的未知网格。

研究人员将额外精心选择的参数引入到表征中,从而允许对提取的网格几何形状和连接性进行本地灵活调整。

在优化下游任务时,这些参数会通过自动微分与底层标量场一起更新。这种提取方案基于双行进立方体,以改进拓扑属性,并提出扩展以选择性地生成四面体和分层自适应网格。

通过大量实验,研究人员在综合基准和实际应用中验证了FlexiCube,表明它在网格质量和几何保真度方面提供了显着改进。

具体来说,FlexiCubes提供了两个显著的优势,可以为各种应用实现简单、高效和高质量的网格优化:

渐进式的优化:网格的微分是明确定义的,基于梯度的优化在实践中有效收敛。

灵活性:网格顶点可以单独进行局部调整,以适应表面特征并找到具有少量元素的高质量网格。

通过可微渲染进行摄影测量

可微分等值曲面技术DMTet是最近工作nvdiffrec的核心,它联合优化了图像的形状、材质和光照。

通过在拓扑优化步骤中简单地用 FlexiCube替换DMTet,保持管道的其余部分不变,我们观察到在相等三角形数量下改进的几何重建。

3D 网格生成

最近的3D 生成模型 GET3D 将3D 表示差异化地渲染为2D 图像,并利用生成对抗框架仅使用2D 图像监督来合成3D 内容。

FlexiCubes可以在3D 生成模型中充当即插即用的可微分网格提取模块,并显着提高网格质量。

使用四面体网格进行可微分物理模拟

FlexiCube可以微分地提取四面体网格。均匀曲面细分允许我们将其与可微分物理模拟框架 (gradSim) 和可微分渲染管道 (nvdiffrast) 结合起来,共同从多视图视频中恢复3D 形状和物理参数。

在这里,研究人员展示了初步结果:给定变形物体的视频序列,他们可以恢复静止姿势的四面体网格,以及在模拟下再现运动的材料参数。

动画对象的网格简化

FlexiCubes 不是在参考姿势中拟合单个网格,而是允许通过现成的蒙皮工具对网格进行不同的蒙皮和变形,并同时针对整个动画序列进行优化。

对整个动画的端到端优化有助于重新分配三角形密度,以避免网格拉伸。

添加网格正则化

FlexiCubes表征足够灵活,可以通过自动微分直接评估依赖于提取的网格本身的目标和正则化器,并将其纳入基于梯度的优化中。

研究人员对提取的网格应用可开发性术语,以促进面板的可制造性。

Top10:使用专家降噪器集合进行文本到图像的扩散

项目地址:https://research.nvidia.com/labs/dir/eDiff-I/

英伟达的研究人员提出了eDiff-I,这是一种用于合成给定文本的图像的扩散模型。

受扩散模型的行为在不同采样阶段不同的经验观察的启发,研究人员训练一组专家去噪网络,每个网络专门针对特定的噪声区间。

模型通过T5文本嵌入、CLIP图像嵌入和CLIP文本嵌入为条件,可以生成与任何输入文本提示相对应的逼真图像。

除了文本到图像的合成之外,我们还提供了两个额外的功能 :

(1) 样式传输,这使我们能够使用参考样式图像控制生成样本的样式

(2) 「用文字绘画」,用户可以通过在画布上绘制分割图来生成图像的应用程序,这对于制作所需的图像非常方便。

模型的工作流程由三个扩散模型的级联组成 :

一个可以合成64x64分辨率样本的基本模型,以及两个可以将图像分别逐步上采样到256x256和1024x1024分辨率的超分辨率堆栈。

模型采用输入标题并首先计算 T5XXL 嵌入和文本嵌入。可以选择使用根据参考图像计算的CLIP图像编码。这些图像嵌入可以用作风格向量。

然后将这些嵌入输入到级联扩散模型中,该模型逐渐生成分辨率为1024x1024的图像。

在扩散模型中,图像合成通过迭代去噪过程进行,该过程逐渐从随机噪声生成图像。

如下图所示,模型从完全随机的噪声开始,然后分多个步骤逐渐去噪,最终生成熊猫骑自行车的图像。

在传统的扩散模型训练中,训练单个模型来对整个噪声分布进行去噪。在这个框架中,研究人员训练了一组专家降噪器,专门用于在生成过程的不同间隔中进行降噪,从而提高合成能力。

eDiff-I和Stable Diffusion对比

风格转化功能

参考资料:

https://twitter.com/DrJimFan/status/1738613195173159187

https://www.youtube.com/watch?v=d7RM-3dQaJ8

相关文章

相关文章

头条焦点

头条焦点

精彩导读

精彩导读 关注我们

关注我们

【查看完整讨论话题】 | 【用户登录】 | 【用户注册】